今天,GLM-4.7-Flash正式发布并开源。

GLM-4.7-Flash是一个混合思考模型,总参数量为30B,激活参数量为3B,作为同级别SOTA模型,为轻量化部署提供了一个兼顾性能与效率的新选择。

即日起,GLM-4.7-Flash将替代GLM-4.5-Flash,在智谱开放平台BigModel.cn上线,并供免费调用。

小而强

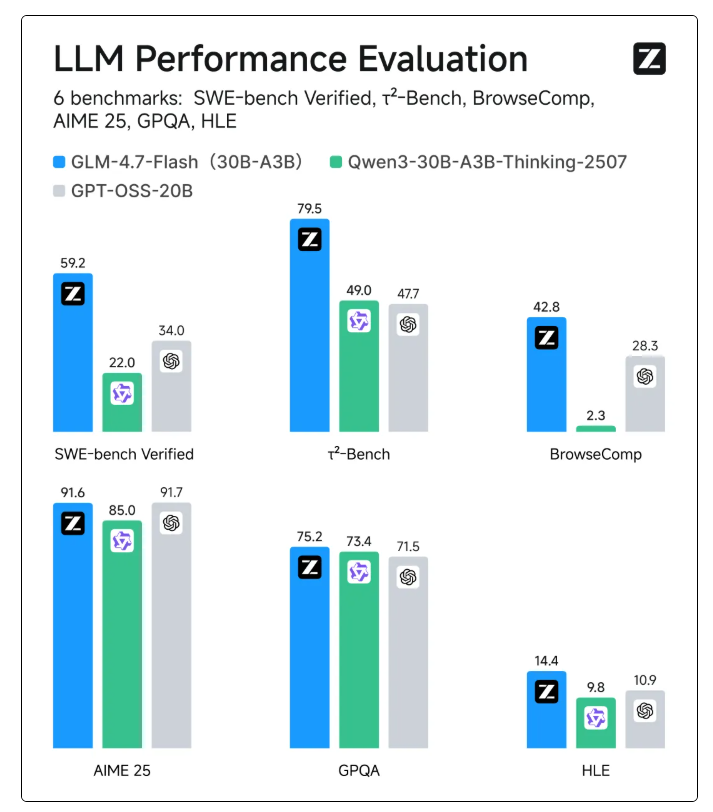

在SWE-bench Verified、τ²-Bench等主流基准测试中,GLM-4.7-Flash的综合表现超过gpt-oss-20b、Qwen3-30B-A3B-Thinking-2507,在相同和近似尺寸模型系列中取得开源SOTA分数。

在内部的编程实测中,GLM-4.7-Flash在前、后端任务上表现出色。在编程场景之外,我们也推荐大家在中文写作、翻译、长文本、情感/角色扮演等通用场景中体验GLM-4.7-Flash。

开始使用

API接入

体验中心:https://bigmodel.cn/trialcenter/modeltrial/text?modelCode=glm-4.7-flash

使用指南:https://docs.bigmodel.cn/cn/guide/models/free/glm-4.7-flash

接口文档:https://docs.bigmodel.cn/api-reference/模型-api/对话补全

上一代免费语言模型GLM-4.5-Flash将于2026年1月30日下线,请您及时将模型编码更新为最新版本。GLM-4.5-Flash正式下线后,相关请求将会自动路由至GLM-4.7-Flash。

开源部署

Hugging Face:https://huggingface.co/zai-org/GLM-4.7-Flash

魔搭社区:https://modelscope.cn/models/ZhipuAI/GLM-4.7-Flash